Los "deepfakes" de audio usados para realizar estafas telefónicas

Un deepfake en vídeo, en el que se suplanta digitalmente a una persona, se han visto como una amenaza para la desinformación. Pero también es posible crear deepfakes de audio y estos abren otros horizontes inquietantes. Como la posibilidad de ser usados para realizar estafas telefónicas.

Pero que no cunda demasiado la alarma. Este tipo de manipulaciones requieren de cierto esfuerzo y conocimientos técnicos por parte de los estafadores. Un esfuerzo que algunos pueden querer realizar si somos un ejecutivo de una compañía eléctrica y con una llamada telefónica podemos transferir 200.000 dólares a una cuenta en Hungría.

Se requiere de una materia prima muy importante para llevar a cabo la estafa, la voz de la persona que va a ser suplantada. Esos son en líneas generales los detalles de una estafa tecnológica de la que informaba The Wall Street Journal. Los estafadores suplantaron la voz del ejecutivo, del que se desconoce su identidad, en una llamada de teléfono. Evidentemente, como en cualquier deepfake, para que esto suceda se requiere de una materia prima muy importante: la voz de la persona que va a ser suplantada. Esta luego es procesada en bloques que se pueden organizar incluso imitando un acento.

Algo que no es demasiado difícil de lograr si esta persona es conocida y por

ejemplo aparece en numerosos vídeos o en cortes de audio. De la misma forma

que un deepfake realizado en vídeo requiere de imágenes de la persona a la que

vamos a suplantar, para que la inteligencia artificial sea capaz de armar una

falsificación sonora coherente es necesario contar con fragmentos de voz de la

persona cuya voz se quiere imitar.

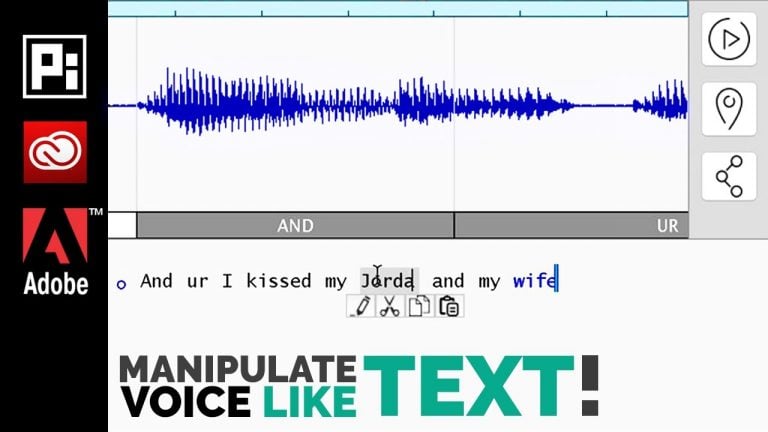

Lyrebird es uno de los posibles software con los que se simula la voz

Pero antes hagamos una aclaración. Los creadores de Lyrebird, el software más popular para simular una voz, aclaran que son conscientes del uso negativo que puede hacerse de su software. Aunque en realidad sus esfuerzos dicen estar más pensados para crear una especie de avatar sonoro con nuestra voz.Algo que por ejemplo permitiría escribir una conversación y que esta sea emitida con nuestra voz en un momento en el que, por ejemplo, no podemos hablar por teléfono. Aunque hay muchos otros usos de algo así. De hecho el límite lo pone la imaginación. No sería descabellado que en el futuro algunos estén dispuestos a prestar su voz a una inteligencia artificial de confianza.

Cuando se presentó la tecnología Duplex de Google [demostración], que permite hacer llamadas telefónicas mediante inteligencia artificial para cosas como reservar un restaurante sin que el interlocutor se percate de que habla con una máquina. Se abrió cierto debate ético cuando apareció esta herramienta. Pero imaginemos que una herramienta como Duplex puede hacer esas llamadas con nuestra propia voz.

Nada indica que Google quiera hacer algo así, pues probablemente sería ir demasiado lejos. De hecho, incluso la empresa ha tomado alguna medida para investigar los deepfake de audio. Por otra parte, hay que aclarar que, según recoge The Washington Post, la tecnología para suplantar la voz de una persona aún no está demasiado madura.

El número de teléfono desde el que se emite la llamada sigue siendo una garantía de que hablamos con quién pensamos que lo estamos haciendo. Prueba de que esto puede ser cierto es que Adobe ha llegado a presentar un sistema similar de software, Adobe Voco, pero parece que no ha pasado la fase de experimento. Otro de los intentos para simular voces ha sido creado por el gigante chino Baidu. Se trata de Deep Voice, que promete simular una voz con una muestra de pocos segundos de audio de una persona hablando. Pero al igual que en el caso de Adobe no hemos vuelto a saber gran cosa de este software.

Aunque es posible que estas empresas no hayan dado rienda suelta a sus experimentos por causas que pueden ser muy diversas: desde la dudosa moral de sus potenciales usuarios hasta la falta de un potencial comercial claro. Pues al fin y al cabo es posible que no sean tantas las personas interesadas en una herramienta de esa clase.

Pero claro los sistemas actuales que simulan voces no son infalibles. Pero los que los usan pueden usar una excusa muy sencilla para explicar a un interlocutor los fallos o los retardos en las respuestas: los problemas de cobertura que pueden darse en las redes telefónicas móviles. Evidentemente el número de teléfono desde el que se emite la llamada sigue siendo una garantía de que hablamos con quién pensamos que lo estamos haciendo.

De hecho, esta es una de las mayores garantías que deberíamos tener en cuenta para saber que la voz que está al otro lado del auricular no es simulada. Aunque si este tipo de manipulaciones avanza en ciertas llamadas se podría solicitar una clave de autentificación antes de dar información. Veremos si iniciativas como Lyrebird o Realtalk, de la empresa Dessa, siguen creciendo o acaban siendo experimentos tan raros como inquietantes.

Ataques de suplantación de identidad a través del rostro

En el artículo Inteligencia artificial y su impacto en la verificación de identidad [1], mencionamos que los sistemas deben incluir cada vez más nuevas estrategias y niveles de seguridad entre los que destacamos la verificación documental, el reconocimiento facial, pruebas de rostro vivo, el reconocimiento de huellas digitales y el análisis de fuentes abiertas.

Los métodos de suplantación de identidad consisten en utilizar rasgos artificiales para reemplazar a un usuario o crear una nueva identidad en el sistema [2]. Estos varían en complejidad, costo y cantidad de esfuerzo y habilidad utilizados en su construcción [3], y pueden ocurrir en i) el momento de verificación, es decir, durante la autenticación presentando al sensor, en este caso la cámara, una copia falsa del usuario, ii) en el momento de identificación o enrolamiento en el cual se crea una cuenta de usuario que será luego utilizado por una persona o personas diferentes a las del enrolamiento y finalmente, iii) crear una nueva identidad para evitar ser detectado [2].

Los ataques de suplantación por rostro más comunes se pueden dividir en dos

grupos, i) utilizando superficies 2D, por ejemplo, fotos o videos, y ii)

utilizando volúmenes 3D, por ejemplo, el uso de máscaras.

- Ataques por medio de fotos: Constituye uno de los ataques más simples y se realiza presentando al sistema de seguridad una foto del usuario real [1]. En los tiempos actuales obtener una imagen de las personas resulta extremadamente sencillo debido al uso que se tiene de las redes sociales, ya que son los mismos usuarios lo que promulgan dicha información. Para realizar el ataque basta con imprimir la foto o proyectarla en alguna pantalla o dispositivo digital.

- Ataques por medio de vídeos: Estos ataques representan una versión de los ataques por medio de fotografías, y consisten en reproducir un vídeo del usuario real por medio de un dispositivo digital; de esta forma es posible reproducir dinámicas y movimientos propios de los individuos [2].

- Ataques por medio de máscaras: Este es un ataque más sofisticado en el que se utiliza una máscara 3D del rostro del cliente. Dependiendo de la calidad de este las dificultades de detectar el fraude aumenta considerablemente ya que la estructura completa del rostro es imitada [2]. Por ahora el costo de realizar una máscara de calidad hace que este tipo de ataques no sea tan utilizado como los dos anteriores, sin embargo, con el aumento y avance tecnológico de la impresión 3D es posible que la brecha se cierre en los próximos años.

[1] R. Manrique, «Inteligencia artificial y su impacto en la verificación de identidad,» ReconoSer ID, Bogotá, Colombia, 2020.

[2] J. G. a. S. M. a. J. Fierre, «Biometric Antispoofing Methods: A Survey in Face Recognition,» IEEE Access, vol. 2, pp. 1530-1552, 2015.

[3] N. E. A. A. a. S. M. Ivana Chingovska, «Face Recognition Systems Under Spoofing Attacks,» de Face Recognition Across the Imaging Spectrum, Bourlai T. (eds), Springer, 2016.

Fuente: La Vanguardia | ReconoSERID

0 Comments:

Publicar un comentario

Gracias por dejar un comentario en Segu-Info.

Gracias por comentar!