Hallan sesgos raciales y de género en el reconocimiento facial de Amazon

El software de reconocimiento facial de Amazon ha vuelto a generar polémica.

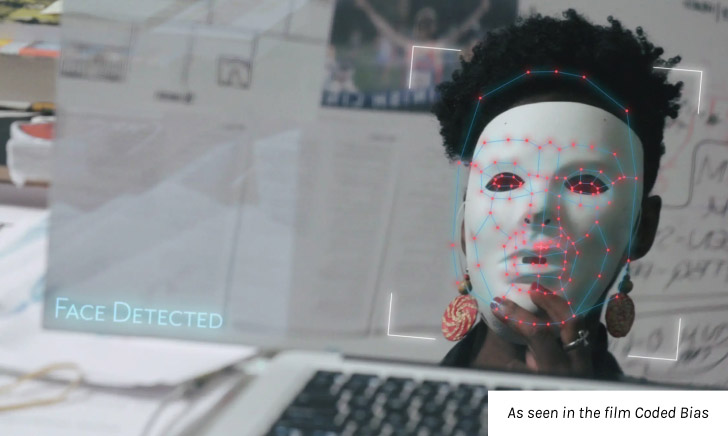

Una investigadora del Instituto Tecnológico de Massachusetts (MIT) encontró

que Rekognition se desempeña peor al identificar el sexo de un individuo si es

mujeres o de tez más oscura.

En el estudio publicado esta semana por el Media Lab de MIT, las pruebas dirigidas por Joy Buolamwini señalan que el software de reconocimiento facial no cometió errores al identificar el género de hombres de piel más clara, pero confundió a mujeres con hombres el 19% de las veces. Además, confundió a mujeres de piel más oscura con hombres el 31% de las veces.

En febrero del año pasado, la investigadora de Media Lab y fundadora de la Liga de Justicia Algorítmica realizó el mismo estudio, en el cual identificó sesgos raciales y de género similares en el software de reconocimiento facial creado por Microsoft, IBM y la firma china Megvii. Después de compartir sus hallazgos, Microsoft e IBM dijeron que mejorarían su software, lo cual ha sido comprobado en este último estudio.Buolamwini, quien es de ascendencia ghanesa, se dedica a hacer conciencia sobre el sesgo de este tipo de software y a hacer que las empresas hagan su tecnología más precisa, pues el sesgo en los algoritmos es frecuentemente resultado de datos de entrenamiento sesgados.

Ante una audiencia en el Foro Económico Mundial de 2019 en Davos, Suiza, la investigadora explicó que este tipo de software son un "reflejo de las prioridades, las preferencias y también a veces los prejuicios de quienes tienen el poder de dar forma a la tecnología", lo cual ha definido como "la mirada codificada".

Tras haber publicado su estudio en febrero pasado, IBM publicó una base de datos curada que, aseguró, aumentaría la precisión de su software. Por su parte, el presidente ejecutivo de Microsoft, Satya Nadella, habló sobre la necesidad de regular este tipo de tecnología para garantizar estándares más altos en el mercado también durante el Foro Económico Mundial de 2019, según recoge CNBC.

En contraste, Amazon negó que esta investigación sugiriera algo sobre la precisión de su tecnología, de acuerdo con The Verge. De acuerdo con la empresa de Jeff Bezos, los investigadores no usaron en sus pruebas la última versión de Rekognition.

Además, la compañía de Seattle asegura que la prueba de identificación de género era un análisis facial que detecta expresiones y características como el vello facial, pero no una identificación facial que hace coincidir los rostros escaneadas con fotografías. Por tanto, según Amazon, son dos paquetes de software separados.

"No es posible llegar a una conclusión sobre la precisión del reconocimiento facial para ningún caso de uso, incluyendo la aplicación de la ley, sobre la base de los resultados obtenidos mediante el análisis facial", dijo Matt Wood, gerente general de aprendizaje profundo e inteligencia artificial de Amazon Web Services, en un comunicado de prensa, informa The Verge.

En julio de 2018, una investigación de la Unión Estadounidense por las Libertades Civiles (ACLU, por sus siglas en inglés) puso a prueba la tecnología de reconocimiento que Amazon vende a las autoridades estadounidenses, demostrando su margen de error. Según sus hallazgos, Rekognition confundió a 28 miembros del Congreso de los Estados Unidos por personas que habían sido arrestadas por cometer un crimen. Los congresistas eran tanto demócratas como republicanos, así como hombres y mujeres de todas las edades. La compañía atribuyó los resultados a la mala calibración del algoritmo.

El nuevo estudio de Buolamwini

señala:

El potencial de usar como un arma y el abuso de las tecnologías de análisis facial no se puede ignorar ni las amenazas a la privacidad o las violaciones de las libertades civiles menoscabas, incluso a medida que disminuyen las disparidades de precisión.El software de Rekognition es actualmente usado por el Servicio de Inmigración y Control de Aduanas de los Estados Unidos (ICE), siendo probado en diversos aeropuertos del país, incluyendo el de Los Ángeles, Nueva York y Orlando. Asimismo, Aduanas y Protección Fronteriza (CBP) está probando esta tecnología en la frontera con México.

Fuente: Hipertextual

como avanza la tecnologia rapidamente.

ResponderBorrar